|

|

|

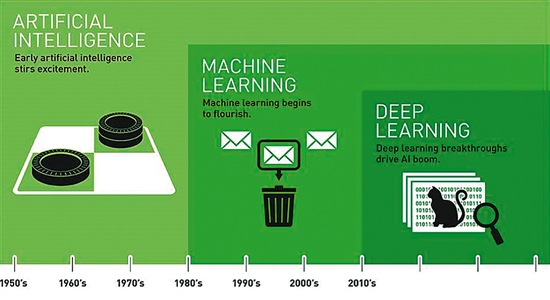

但AI生态一直处于“不温不火”的状态,让业界为AI前途多了几分担忧,特别是算力稀缺问题难以解决,更是为其蒙上了一层阴影。 在“AI寒冬将至”的疑惑之中,后入局的华为却丝毫没有放慢其前进的脚步,一年之内,AI处理器、计算框架相继落地。 “让算力更加普惠,让算法更加简单”,即将举行的2019全联接大会,华为又将发布最新的AI和云产品与解决方案。答案即将浮出水面。 AI寒冬将至? 1956年,时任达特矛斯学院助理教授的约翰·麦卡锡组织召集了达特矛斯讨论,与会学者第一次正式提出“人工智能”的定义。 多年来,深度学习一直处于人工智能革命的最前沿,许多人相信深度学习将带领我们进入新的时代。然而,从几年前如火如荼到如今的逐渐冷却,浪潮一再的退去。面对疲软的风口,人工智能将何去何从,AI寒冬是否将至,深度学习能否助力AI技术续写辉煌? 深度学习的“新江湖” 深度学习与人工智能的关系,简单来说就是:将海量数据通过深度学习进行处理后形成一个模型,再将模型应用到具体的业务环境中,这就是人工智能。 深度学习只是人工智能的一种实现方式,属于机器学习的子集。深度学习本来并非一种独立的学习方法,其本身也会用到有监督和无监督等学习方法来训练深度神经网络。但由于近几年该领域发展迅猛,一些特有的学习手段相继被提出,因此越来越多的人将其单独看作一种学习的方法。 最初的深度学习是利用深度神经网络来解决特征表达的一种学习过程。为了提高深层神经网络的训练效果,人们对神经元的连接方法和激活函数等方面做出相应的调整。其实有不少想法早年间也曾有过,但由于当时训练数据量不足、计算能力落后,因此最终的效果不尽如人意。 随着海量标注数据的出现和算法的不断提升,深度学习摧枯拉朽般地实现了各种任务,使得似乎所有的机器辅助功能都变为可能。 深度学习如此无所不能,主要得益于数据、算法、算力三者的共同提升。现在可以利用的数据特别是人工标注的数据比较丰富,使得人类能从数据中学到更多东西。技术上的发展使得超大规模的模型训练也成为了可能,比如上千层的深度神经网络,这在以前不可想象。 但超大规模模型的复杂度成指数级增加,NLP领域的BERT,就包含约3.4亿个参数,相比AlexNet等网络,算力需求增长了一万倍。这也是OpenAI等组织说AI算力大概每年增长10倍的重要原因之一。 目前,各研究机构和大学科研室的算力资源一直处于紧张的状态,大家经常排队递交训练作业,几天才能等到结果。这也引来了深度学习领域的经典灵魂拷问:深度学习什么研究方向对算力要求不高?如何降低算法对算力的需求? 华为AI“破阵” 面对汹涌而至的海量数据和不断复杂的算法,全球每年新增数据20ZB,AI算力需求每年增长10倍,这一速度已经远超摩尔定律关于性能翻倍的周期。 如何解决这一问题业界有不同的探索。这其中,最根本的方案还是通过硬件和系统的设计提升算力的供给程度,比如华为发布的昇腾系列AI处理器,采用达芬奇架构的AI内核针对深度学习进行优化设计,包含矩阵计算单元、向量计算单元和标量计算单元,结合了GPU、TPU、CPU的优点。尤其对于深度学习领域常用的矩阵乘加运算有数十倍的效率提升。其面向训练领域的昇腾910 AI处理器,单芯片即可提供256TFLOPS的超强计算能力,是业界水平的两倍。 但仅有芯片是不够的,还需要通过高速低延时网络将芯片组合起来,释放出AI处理器的强大性能,配合数据并行、模型并行等的系统级优化设计才能提供超出现有水平的算力高峰。 据了解,2019华为全联接大会上就将推出这方面的AI新品,如何破解算力稀缺难题,华为看来还有大招。 (宋毅)